Постоянное развитие нейронных сетей, используемых в системах распознавания лиц, не избавляет методы 3D-фотобиометрии от уязвимостей. О противоборствующих технологиях EADaily рассказал исполнительный директор, начальник управления статистического анализа банка «Ренессанс Кредит» Сергей Афанасьев.

Первые попытки обмануть системы распознавания лиц: например, нанести на лицо специальный макияж, надеть очки с разрисованной оправой, или купить кепку со светодиодами, о которых уже рассказывало EADaily, теперь представляются детскими шалостями. Вслед за вышеупомянутыми способами пришли так называемые генеративно-состязательные сети.

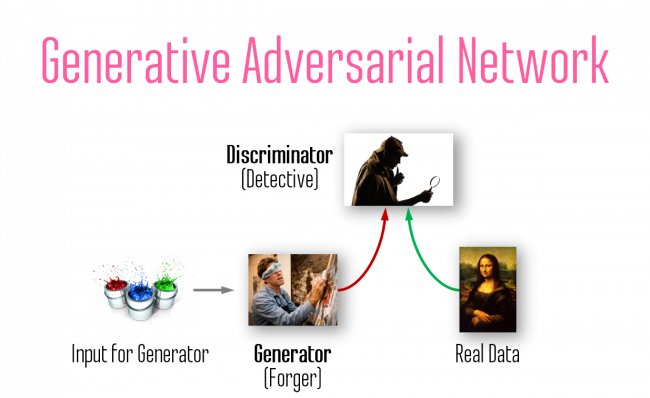

Генеративно-состязательные сети (GAN) были предложены американским математиком Яном Гудфеллоу в 2014 году. Принцип работы ГАНа достаточно прост: сеть состоит сразу из двух нейронных сетей — генератора и дискриминатора. Задача генератора создавать искусственные данные (фотографии, голоса, мелодии и т. п.), а задача дискриминатора попытаться отличить сгенерированные данные от настоящих. Таким образом при обучении ГАНа происходит некоторая антагонистическая игра — генератор пытается обмануть дискриминатор, а дискриминатор пытается выявить этот обман. За счет такой соревновательной концепции с помощью ГАНов получается генерировать данные очень высокого качества.

ГАНы быстро стали популярными и нашли свое применение в таких приложениях как PRISMA, MSQRD, виртуальный макияж ModiFace, виртуальная примерочная Wannaby и другие.

Но также быстро проявилась и темная сторона ГАНов. В конце 2017 года на ресурсе Raddit пользователь под ником Deepfakes выложил несколько видео низкого социального содержания, в которых лица действующих героинь были заменены на голливудских звезд.

Всего через пару месяцев, в январе 2018 года, в интернете появилось приложение FakeApp, с помощью которого можно было подставлять лицо любого человека в любое видео. Причем для работы в приложении не нужно было обладать навыками программирования или специальными знаниями о нейронных сетях — любой пользователь мог создать свой дипфейк (почему-то больше всех в этих экспериментах досталось Николасу Кейджу).

Однако в первой версии FakeApp для создания качественного дипфейка требовалось загружать несколько фотографий лица человека, снятого с разных ракурсов, а рендеринг видео мог отрабатывать всю ночь. При этом в любительских дипфейках было много графических артефактов.

В 2019 году израильские ученые решили проблему низкой скорости разработки дипфейков, предложив нейронную сеть FSGAN, которая позволяет в режиме реального времени заменять лица на видео, не требуя для этого длительной обработки. Авторы разработки утверждают, что в отличие от предыдущих подходов deepfakes, их метод работает для любых двух лиц без какой-либо специальной обработки изображений (проверено на Николасе Кейдже!)

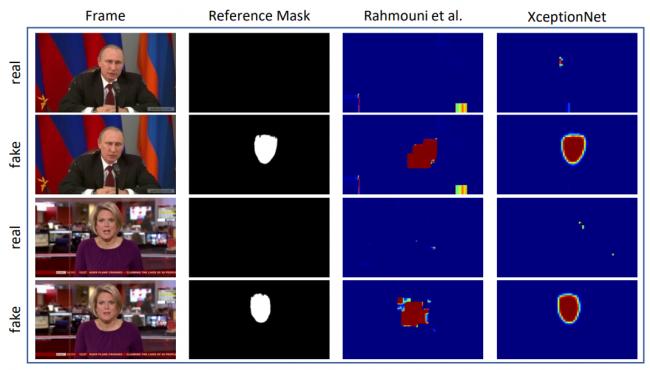

Сразу после появления дипфейков началась «борьба снаряда и брони». В 2018 году немецкие и итальянские ученые разработали нейросеть XceptionNet, которая умеет выявлять подмену лиц на фото или видео. По точности распознавания XceptionNet превосходила существующие на тот момент алгоритмы в несколько раз даже при оценке на сжатых видео. Интересно, что это исследование спонсировалось агентством DARPA департамента обороны США.

«Антидипфейк-нейронки» применяются и для защиты фотобиометрических систем как одна из разновидностей Liveness Detection — технологии, которая позволяет убедиться, что перед фотокамерой находится живой человек, а не заранее сделанная фотография или видеозапись.

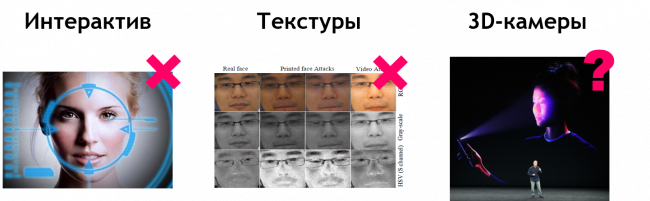

Есть несколько видов Liveness Detection для фотобиометрических систем.

Интерактивное подтверждение — когда человека просят подмигнуть на камеру, или улыбнуться, или покачать головой. Причем, чтобы это действие не было предварительно записано на видео, система просит выполнить его из случайно выбранных. Однако, такая защита легко обходится, например, с помощью всё той же кепки с инфракрасными светодиодами: перед камерой будет стоять живой человек с инфракрасными пятнами на лице. Также интерактивное подтверждение можно обойти с помощью дипфейков, которые позволяют «приклеивать» лицо другого человека в реальном времени (аналог «анимоджи» для смартфонов).

Анализ текстур — позволяет выявлять дипфейки и распознавать, что фотография сделана с плоского изображения. Но кепка со светодиодами работает и тут.

3D-камера — тоже считается технологией Liveness Detection, хотя по сути является 3D-фотобиометрией, которой оснащены, например, iPhone X. Такую защиту сложнее обойти, чем интерактив или текстуры, но, к сожалению, 3D-камеры тоже уязвимы.

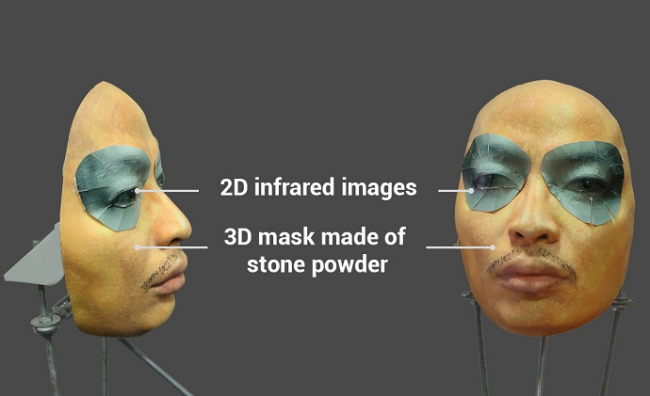

Уязвимость 3D-фотобиометрии продемонстрировали вьетнамские инженеры из компании Bkav, занимающиеся технологиями кибербезопасности. Всего через пару недель после релиза iPhone X они продемонстрировали, как можно взломать FaceID с помощью маски, напечатанной на 3D-принтере. Для этого понадобилось предварительно отсканировать лицо владельца смартфона с помощью 3D-сканера. Первая версия маски состояла из четырех компонент: напечатанной на 3D-принтере основе, 2D изображения глаз, силиконового носа и специально рассчитанной области лица. Вторая версия маски была упрощена до двух компонент: каменной 3D-основы и 2D-изображения глаз.

После публикации этой новости некоторые специалисты по кибербезопасности утверждали, что такой подход не масштабируем, поскольку нужно долго сканировать лицо владельца смартфона. И, возможно, они действительно были бы правы, если бы к тому моменту не придумали ГАНы.

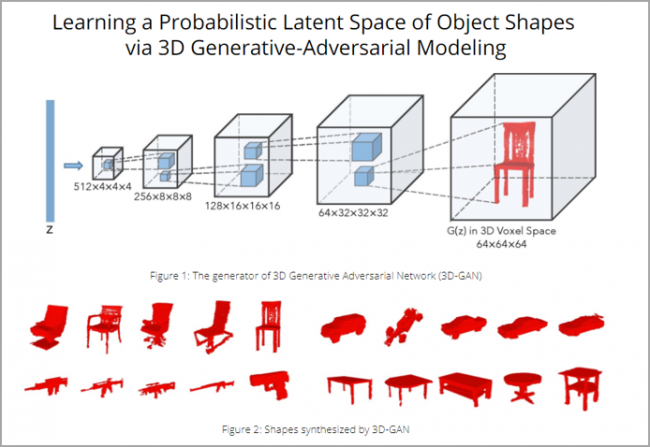

В 2016 году инженеры из Массачусетского технологического института (MIT) разработали нейронную сеть 3D-GAN, которая позволяет восстанавливать 3D-модели высокого качества по 2D-изображению.

Если обучить такую нейросеть на фотографиях лиц, можно создать 3D-маску любого человека, фотографию которого можно достать, например, из социальных сетей.

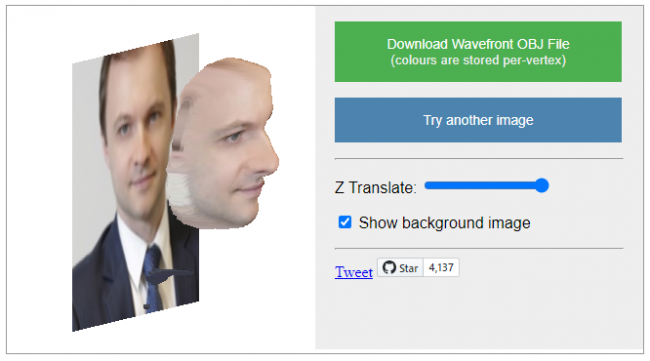

Уже в 2017 году британские ученые развили эту идею и разработали нейронную сеть VRN, которая создает 3D-маску человека всего по одной фотографии. Разработку поместили в открытый доступ, а демо-версию работы этой нейросети можно протестировать здесь.

Возможно, восстановленные с помощью нейронных сетей 3D-маски пока еще не достаточно точны по сравнению с масками, созданными с помощью 3D-сканеров. Но мы помним, что свёрточные нейронные сети, лежащие в основе фотобиометрии, выделяют очень грубые признаки без глубокой детализации, иначе человек не смог бы пройти фотобиометрию повторно.

После взлома FaceID специалисты из компании Bkav в своем блоге описали другой способ масштабирования взлома 3D-биометрии: 3D-маску можно воссоздавать, снимая фотографию с двух камер, расположенных со сдвигом (стереосъемка). Собственно, так и работает большинство 3D-сканеров.

Умерший Шан Цзун из Mortal Kombat оказался православным россиянином Пантелеимоном

Умерший Шан Цзун из Mortal Kombat оказался православным россиянином Пантелеимоном Россия снимет ограничения на денежные переводы за рубеж для белорусов

Россия снимет ограничения на денежные переводы за рубеж для белорусов Военные Минобороны России под Северском наткнулись на вэсэушников-бомжей

Военные Минобороны России под Северском наткнулись на вэсэушников-бомжей В Чехии будет назначен новый премьер-министр

В Чехии будет назначен новый премьер-министр В Киеве сотрудники СБУ, НАБУ и САП пришли с обыском к депутату Рады Анне Скороход

В Киеве сотрудники СБУ, НАБУ и САП пришли с обыском к депутату Рады Анне Скороход Британские социологи бьют тревогу: среди белорусов рекордный уровень поддержки России

Британские социологи бьют тревогу: среди белорусов рекордный уровень поддержки России